撰文:宋杰

突破技术

制造出稳定的量子比特。比特是传统计算机中的信息单位,而量子比特是量子计算机的信息单位。

重要意义

在运行人工智能程序以及处理复杂的模拟和规划问题时,量子计算机的速度可能是传统计算机的指数倍,而量子计算机甚至能制造出无法破解的密码。

技术成熟期

4~5年

主要研究者

- 荷兰量子技术研究所QuTech

- 英特尔

-微软

-谷歌

-IBM

量子通信卫星“墨子号”的成功发射,在全世界范围内再次掀起了一股量子信息研究的热潮。量子信息是以量子物理学为基础的新一代信息科学技术,它包含两个方面:一方面是信息的传输,即量子通信;另一方面是信息的处理,即量子计算。量子通信属于量子信息领域中最先实用化和产业化的方向,“墨子号”就是量子通信实用化的典范。相比之下,目前的量子计算就像一头蹒跚学步的小狮子,要想成为真正的百兽之王,它还有很长的一段路要走。但是,千万别轻视这个小生命,假以时日,它必将震撼世界。

神奇的“量子计算”

量子计算的潜力到底有多大?打个比方,如果把量子计算机的运算速度比作长征五号运载火箭的话,那么今天的超级计算机的速度只能是一辆摩拜单车。

按照中科院量子信息与量子科技前沿卓越创新中心张文卓的话说:“如果一台量子计算机的单次运算速度达到目前民用计算机 CPU 的级别,那么一台 64 位量子计算机的速度将是目前世界上最快的‘天河二号’超级计算机的545 万亿倍。”换句话说,如果按照这样的运算速度求解一个数亿变量的方程组,“天河二号”需要 100 年,而万亿次的量子计算机理论上只需要0.01秒。

为什么量子计算机具有如此惊世骇俗的运算能力?我国科技部973项目“量子通信和量子信息技术”的首席科学家郭光灿是这样解释的[1]:“量子比特可以制备在两个逻辑态0和1的相干叠加态,换句话讲,它可以同时存储0和1。考虑一个N个物理比特的存储器,若它是经典存储器,则它只能存储2∧N个可能数据当中的任意一个;若它是量子存储器,则它可以同时存储2∧N个数,而且随着 N的增加,其存储信息的能力将呈指数上升。比如,一个250个量子比特的存储器(由250个原子构成)可能存储的数据达2∧250,比现有已知的宇宙中的全部原子数目还要多。

“由于数学操作可以同时对存储器中全部的数据进行计算,因此,量子计算机在实施一次运算时可以同时对2∧N个输入数进行数学运算。其效果相当于经典计算机要重复实施2∧N次操作,或者采用2∧N个不同处理器实行并行操作。可见,量子计算机可以节省大量的运算资源(如时间、记忆单元等)。”

因此,让世界快2n绝不是天方夜谭。但是,和所有改变人类历史进程的重大发现一样,量子计算的诞生之路并不平坦。从普朗克提出量子的概念至今,量子力学已经走了100多年的历程。在这100年中,量子力学给人类的生活带来了翻天覆地的变化,尤其是在20世纪后半叶,激光器的出现和半导体工业的突飞猛进,彰显了量子科学的巨大威力。但即便是这样成功的理论,围绕它的争论却从来未曾间断。对其提出质疑的人当中不乏这一领域的开创者,如薛定谔、爱因斯坦等人,而拥护量子力学的则是以玻尔和海森伯等人为代表的哥本哈根学派。他们争论的焦点在于:量子力学描述的物理存在具有无法消除的随机性,而这是以爱因斯坦为代表的持经典决定论观点的物理学家所不能接受的,他们认为量子力学对物理世界的描述是不完备的,世界应该被更为基础的理论来支配。

随着论战的升级,爱因斯坦等人提出了量子纠缠态的概念,进而引发了对量子力学基本原理的检验。虽然迄今为止,绝大多数的证据显示了哥本哈根学派的胜利,似乎围绕这一科学问题的争论暂时告一段落,但是,正是由于这两股科学洪流的不断砥砺和求索,使人们加深了对这门科学的认识,也为后来量子信息科学的诞生奠定了基础[2]。

20世纪微电子技术的迅速发展,大大提高了电子计算机集成电路的集成度,为现代信息化社会打下了物质基础。1965年,Intel的创始人之一——摩尔提出了以他名字命名的摩尔定律。这个定律认为,差不多每18个月以同样价格所能买到的计算机的计算能力就可以翻上一番。随着集成电路集成度的日益提高,电路板蚀刻精度也将越来越高,中央处理器芯片上集成的晶体管器件就会越来越密,这将迫使电路线宽不断狭窄,直至狭窄到不得不考虑运动在电路中电子的波动性将在电路中产生新的物理现象——量子效应(当电路线宽小于0.1微米)时,现有的芯片制造理念将不再适应。为了克服这个困难,一门新的学科——量子信息学应运而生。量子信息不仅仅是利用量子力学的物化产品(如半导体器件),而是直接以量子力学原理为基础、充分利用量子独特的性质,如量子叠加、量子纠缠和量子不可克隆等,探索以全新的方式进行编码、信息传输和计算[3]。

量子信息是量子物理与信息科学相融合的新兴交叉学科,自其诞生以来就引起了国际学术界的巨大兴趣,受到西方各国的高度重视,得到迅速发展,迄今方兴未艾!量子信息技术基于量子特性,如量子相干性、非局域性、纠缠性、不可克隆性等,可以实现现有信息技术无法做到的诸多信息功能,比如,量子计算机可以加速某些函数的运算速度,攻破现有的密钥体系,量子因特网具有现有因特网所无法比拟的优点,量子密码可提供不可破译、不可窃听的保密通信等。量子信息技术可以突破现有信息技术的物理极限,为信息科学的发展提供新的原理和方法, 21世纪信息科学将从经典比特跨跃到量子比特时代。量子信息技术是后摩尔时代的重要新技术,将来有望形成量子信息技术(Quantum Information Technology)新产业,因而,量子计算成为各国未来高技术的战略竞争焦点之一。

量子计算的超强能力来源于其绝无仅有的神奇特征。要想弄清楚量子计算为何如此强大,就必须了解它的3个秘密武器。

量子比特

传统的信息技术扎根于经典物理学,一个比特在特定时刻只有特定的状态,要么是0,要么是1,所有的计算都按照经典的物理学规律进行。量子信息扎根于量子物理学,一个量子比特(qubit)就是0和1的叠加态,相比一个经典比特只有0 和1 两个值,一个量子比特的值有无限个。

量子的不可克隆定理

为什么说量子不能被克隆呢?我们可以用反证法进行证明。如果任意量子态可以被精确克隆,那么我们就可以这么做:先把这个量子态精确地复制100份,然后用100种不同的测量方法来精确地得到100种不同的信息——如果100份还不够,那么就克隆10000份好了。通过选择测量方法,我们就可以知道每个特定备份的相关性质,再加上精确克隆的假定,我们就可以知道任意量子态的任何信息,海森堡测不准原理也就不可能成立了——这个结论与实验观测事实是矛盾的。所以说,量子不可克隆原理等价于海森堡测不准原理,也等价于测量会影响量子态的这个量子力学基本假定。

量子不可克隆原理告诉我们,如果你只有一个光子,而且事先不知道它的偏振状态,那么你就不可能复制出两个完全相同的光子,更别说100万个了。这就是“墨子号”量子通信卫星的理论基础。

量子纠缠

量子力学中最神秘的就是量子叠加态,而“量子纠缠”就是多粒子的一种量子叠加态。以双粒子为例,一个粒子A可以处于某个物理量的叠加态,同时另一个粒子B也可以处于叠加态。当2个粒子发生纠缠时,就会形成一个双粒子的叠加态,无论2个粒子相隔多远,只要没有外界干扰,当A粒子处于0 态时,B 粒子一定处于1 态;反之,当A粒子处于1 态时,B粒子一定处于0态。

用薛定谔的猫做比喻,就是A和B两只猫如果形成上面的纠缠态:

无论两只猫相距多远,即便在宇宙的两端,当A猫是“死”的时候,B 猫必然是“活”;当A猫是“活”的时候,B猫一定是“死”(当然,真实的情况是,猫这种宏观物体不可能把量子纠缠维持这么长的时间,10~30 秒内就会解除纠缠。但是基本粒子是可以长时间保持纠缠的,如光子)。

传统计算机的终结者

正是由于量子计算的独特性质,使其具有了传统计算机所无法企及的超强能力。量子计算可以说是传统计算机的“终结者”,它战胜传统计算机的两大致胜法宝到底是什么呢?法宝一,是量子计算相较于传统计算机呈指数级增长的计算能力。经典计算机中,一个经典比特只能存储一位信息,要么是1,要么是0。但是在量子计算机中,这个比特可以是 0 ,也可以是 1 ,关键是它们同时参与了计算,而只在你观测时才会塌缩成一个完全确定的解答。假如是 10 个经典比特,那么相当于 10 位数据参与运算。而10个量子比特就是2∧10,也就是1024位数据参与了运算,这是多么巨大的差距。

法宝二,是量子计算的可逆性。正是由于量子计算具有可逆性,才使它的能耗和传统计算机相比大幅降低。我们现在计算机的主要热量,来源于我们对存储器的不断读写和重置。假设我们的存储器内有 0 和 1 组成的杂乱无章的数据,现在我们全部清零,这一刻我们的存储器显然变得更加“有序”,即无序程度“熵”的降低,而根据热力学定律,这些熵就以热量的形式散发出去。因为微观粒子的幺正性,量子的运算是一种完全可逆计算,信息不会丢失而得到重用,几乎不会有热量的散失。设想一下,未来你的笔记本电脑可以用一个纽扣电池续航一周,而且运算速度是现在计算机的数亿倍,那是一件多么美好的事情!

量子计算的两大算法

读到这儿,你可能会说,量子计算的特点和法宝我已经明白了,看起来完成量子计算并不难,那么量子计算机的实现一定指日可待了吧?对不起,答案是否定的。虽然我们已经明确了量子计算的原理,但要想实现量子计算机这个终极目标,还有两个巨大的难题摆在科学家的面前——算法和物理实现。那么现在已经发明的量子计算的“明星算法”有哪些呢?

Shor算法

要想开拓出量子计算机巨大的并行处理能力,必须寻找适用于这种量子计算的有效算法。Shor于1994年发明了第一个量子算法,它可以有效地用来进行大数因子分解。

大数因子分解是现在广泛用于电子银行、网络等领域的公开密钥体系 RSA安全性的依据。采用现有计算机对数N(二进制长度为log N)做因子分解,其运算步骤(时间)随输入长度(log N)指数增长。迄今在实验上被分解的最大数为129位,1994年在世界范围内同时使用1600个工作站花了8个月时间才成功地完成了这个分解。若用同样的计算功能来分解250位的数则要用80万年,而对于1000位的数,则要用10∧25年。

与此相反,量子计算机采用 Shor算法可以在几分之一秒内实现1000位数的因子分解,而且操作时间仅随输入数的3次方增长。可见Shor量子算法将这类“难解”问题变成了“易解”问题。在量子计算机面前,现有公开密钥RSA体系将无密可保!

Shor的开创性工作有力地刺激了量子计算机和量子密码术的发展,成为量子信息科学发展的重要里程碑之一。

Grover算法

1997年,Grover发现了另一种很有用的量子算法,即所谓的量子搜寻算法,它适用于解决以下问题:从 N个未分类的客体中寻找出某个特定的客体。经典算法只能是一个接一个地搜寻,直到找到所要的客体为止,这种算法平均地讲要寻找 N/2次,成功的概率为50%,而采用Grover的量子算法则只需要 次。比如,要从有着100万个电话号码的电话本中找出某个指定号码,该电话本是以姓名为顺序编排的。经典方法是一个个地找,平均要找50万次才能以50%的概率找到所要的电话号码。 Grover的量子算法是每查询一次可以同时检查所有100万个号码。由于100万个量子比特处于叠加态,量子干涉的效应会使前次的结果影响到下一次的量子操作,这种干涉生成的操作运算重复1000(即

次。比如,要从有着100万个电话号码的电话本中找出某个指定号码,该电话本是以姓名为顺序编排的。经典方法是一个个地找,平均要找50万次才能以50%的概率找到所要的电话号码。 Grover的量子算法是每查询一次可以同时检查所有100万个号码。由于100万个量子比特处于叠加态,量子干涉的效应会使前次的结果影响到下一次的量子操作,这种干涉生成的操作运算重复1000(即 )次后,获得正确答案的概率为50%。但若再多重复操作几次,那么找到

)次后,获得正确答案的概率为50%。但若再多重复操作几次,那么找到

Grover算法的用途很广,可以寻找最大值、最小值、平均值等,也可以用于下棋。最有趣的用途是可以有效地攻击密码体系,如DES体系。这个问题的实质是从256=7×1016个可能的密钥中寻找一个正确的密钥。若以每秒100万密钥的运算速率操作,经典计算需要1000年,而采用Grover算法的量子计算机则只需小于4分钟的时间。难怪Grover以“量子力学可以帮助在稻草堆中寻找一根针”这样的题目在 PRL上公布他的算法。

虽然量子计算领域已经诞生了一些非常有效的算法,但它们的数量还远远不够。各国科学家正从不同途径来探索实现量子计算的算法,虽然量子计算不断地取得进展,在《自然》《科学》杂志上每年都有许多重要的进展发表,但仍未从根本上取得突破。看来,量子计算在算法领域还有许多疆域需要我们去开拓。

量子计算的另一个挑战:物理实现

虽然“明星算法”为量子计算指明了前进的方向,但是如果不能将量子计算机的物理基础搭建起来,那这一切都是无源之水、无本之木。

制造量子计算机的困难在于要找到可以编码的量子比特,并且能够有效地被外界控制,但又与环境有很好的隔离,不会使系统很快消相干失去量子特性的物理系统。Di Vincenzo关于量子计算的物理实现技术提出了著名的7个判据[5]。他认为,对于任何一种可行的量子计算实现技术,以下条件是必要的。

(1)可扩展的具有良好特性的量子比特系统。

(2)能够制备量子比特到某个基准态。

(3)具有足够长的时间来完成量子逻辑门操作。

(4)能够实现一套通用的量子逻辑门操作。

(5)能够测量量子比特。

(6)能够使飞行量子比特和静止量子比特互相转化。

(7) 能够使飞行量子比特准确地在不同的地方之间传送。

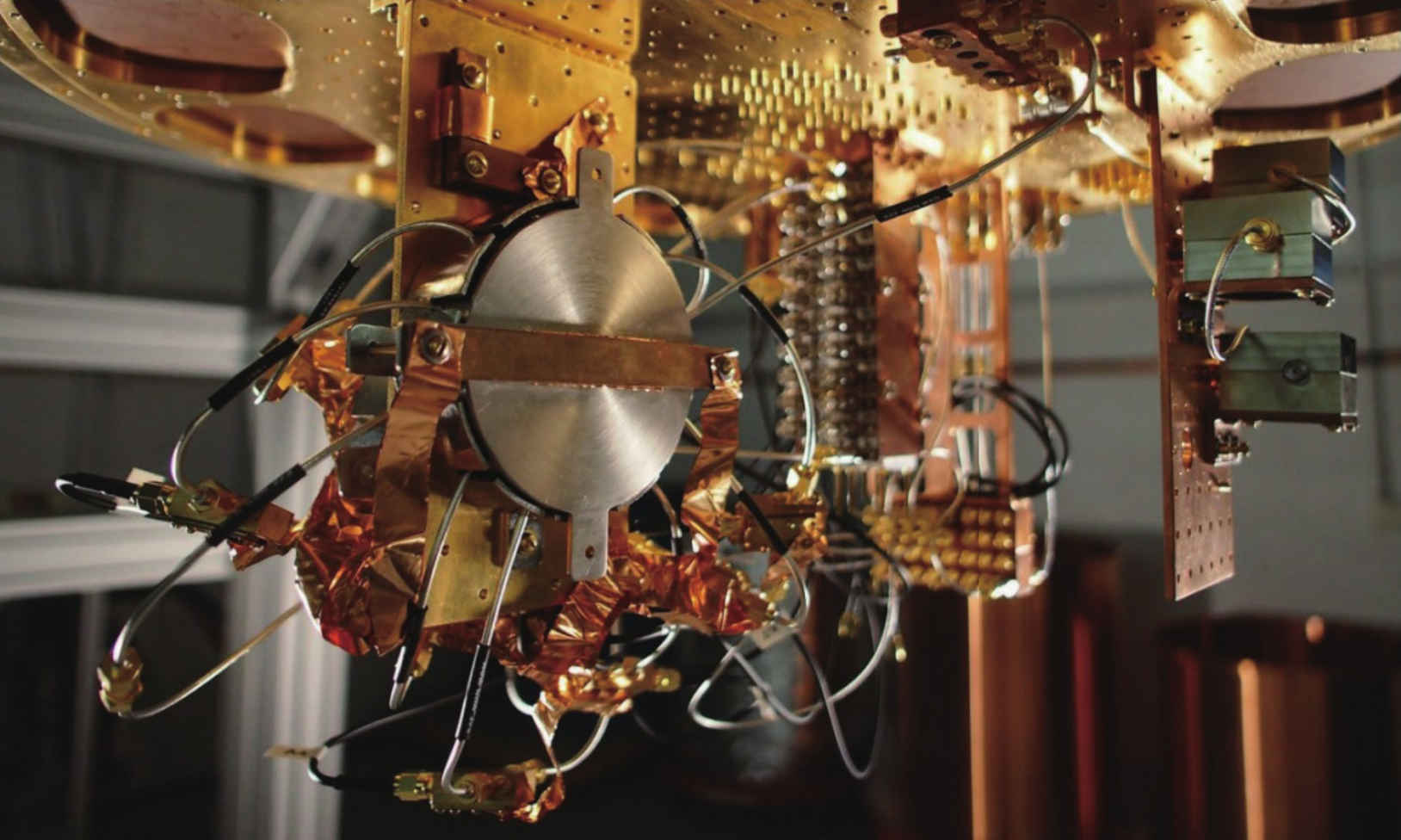

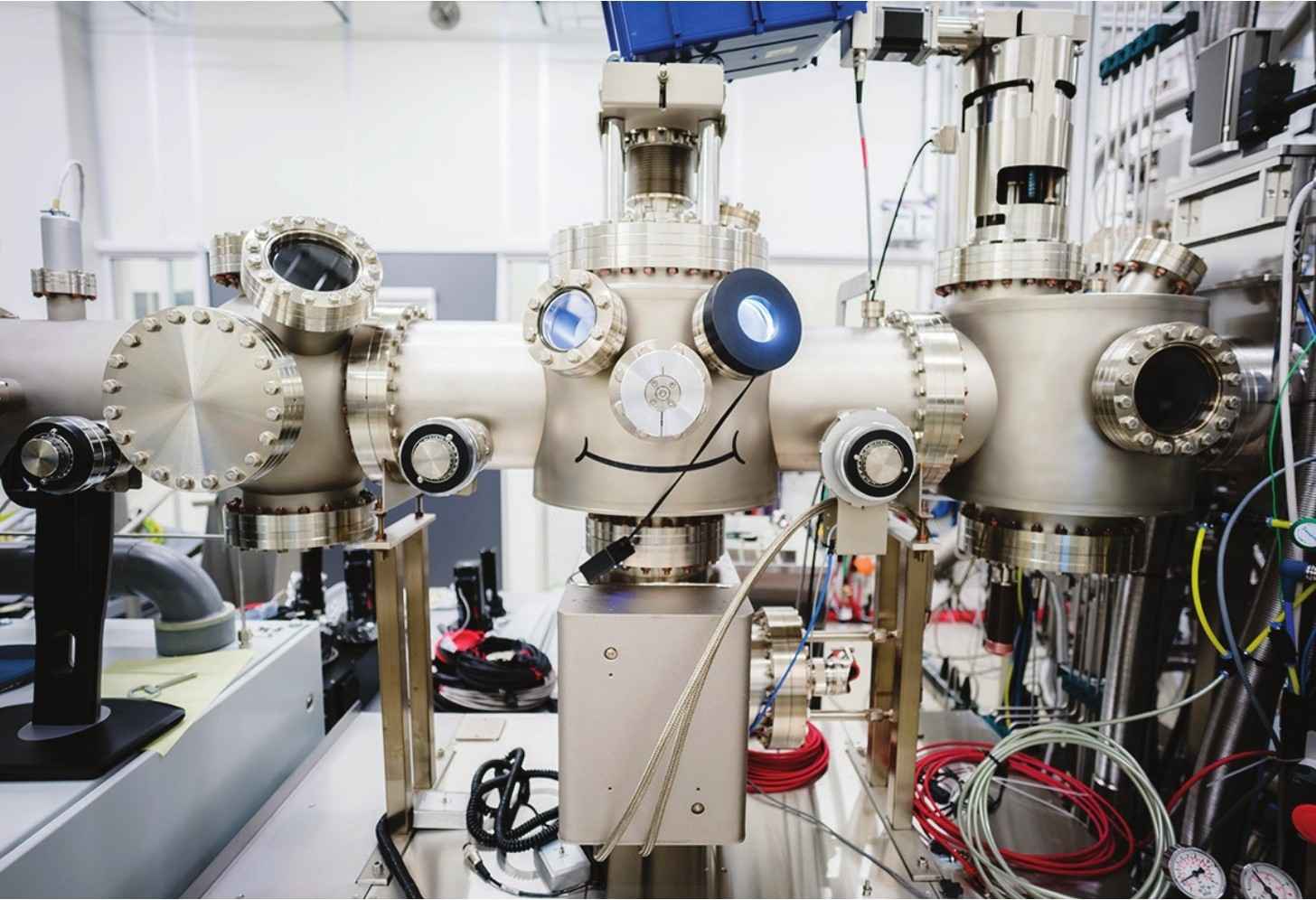

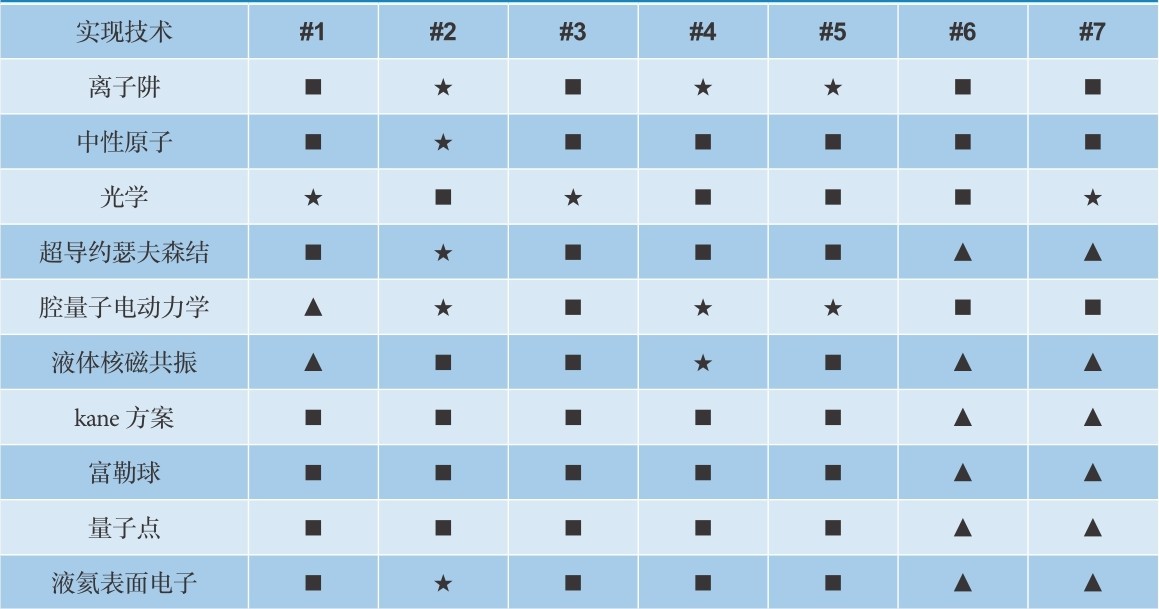

虽然目前的科学和技术条件距离实现一个实用的量子计算机还有很大的距离,但是已经有一些科学技术手段可以实现对几个量子比特的控制操作。目前,学者们已经提出了多种量子计算的实现技术和方案,包括离子阱、光学、量子点、超导约瑟夫森结、腔量子电动力学、液体核磁共振、Kane的硅基半导体方案、富勒球、中性原子和液氦表面电子等,其中有些实现技术已经成功地实现了简单的量子算法。

离子阱方法

利用离子阱技术实现量子计算是Cirac和Zoller在1995年首次提出来的。2003年,奥地利因斯布鲁克大学的Blatt研究小组利用离子阱技术成功地实现了Cirac-Zoller控制非门,同年,同一研究小组利用离子阱技术第一次成功地演示了Deutsch -Jozsa算法。离子阱技术的优点是具有较长的相干时间(可达10分钟),有较高的制备和读出量子比特的效率。目前,已经有人提出了建造大规模离子阱量子计算装置的设计方案。

离子阱方法有待解决的问题是引起离子运动消相干的电场波动的来源目前还不是十分清楚,能储存多条离子链的离子阱在实验上很难实现,离子的自发辐射会导致消相干,激光的相位和强度的波动会影响对离子的操作,也会导致消相干。量子信息和量子计算研究的一个重要目的就是把信息的特性与物理规律联系起来,离子阱量子计算为研究这种联系提供了具体和完整的研究途径。

光学方法

光学方法不仅在量子信息研究中非常重要,在量子计算领域也是一个十分重要的手段和研究方向。光学方法差不多在量子信息研究的每一个领域都有贡献,其中包括量子远程传态、量子密码、多粒子量子纠缠、量子态和量子过程的重建以及简单量子算法的实现等。事实上光子是一种十分理想的量子比特的载体:光子的偏振和光子的路径信息都可以用来编码量子比特;用各种半波片和半透镜等光学器件就可以完成对量子比特的单比特操作;而且目前的单光子探测技术可以对光子进行令人满意的测量。

一个通过事后选择实现CNO门的光学方法(量子比特由光子的不同偏振态编码,光子之间的相互作用由事先制备的纠缠提供),光子与环境的相互作用很小,具有很好的相干性,但同时也带来了一个问题:光子之间几乎没有相互作用,无法实现2个量子比特直接的逻辑门操作。虽然基于线性光学器件和单光子源的量子计算方案在2001年就被提出来了,但在2003年研究人员才首次通过光学方法利用纠缠光子对明确地实现了2个量子比特的逻辑门控制,但这种现象是概率性的。

光学方法有很多其他方法所不能比拟的优点:光子是飞行比特,天然适合于分布式量子计算;精确的单比特操作;光学中有许多相当成熟的技术可以利用;与量子通信直接兼容;目前最成熟的纠缠源就是参量下转换过程(parametric down-conversion)所产生的纠缠光子源。

量子点方法

量子点方法是指利用半导体制备技术制造的一种砷化镓量子点(Ga As QDs)。量子点中的电子自旋可以作为量子比特,在一个典型条件下(300m K,5T),平衡态的量子点中的电子自旋向上的概率为99%。利用电子的泡利不相容原理,通过自旋和电荷之间的关联,可以通过普通的电子开关对电子自旋进行控制。原理上可以通过电子的电荷及电子的库仑相互作用完成对电子自旋编码的量子比特的各种操作,包括单量子比特操作和两量子比特操作及结果的读出。

目前的量子点量子计算处于装置结构的制造和基本性质的研究的阶段,距离实现量子计算的7个条件还有很多工作要做。但作为一种固体量子计算实现技术,它可以借助很多现在的半导体制造技术和经典电子技术。

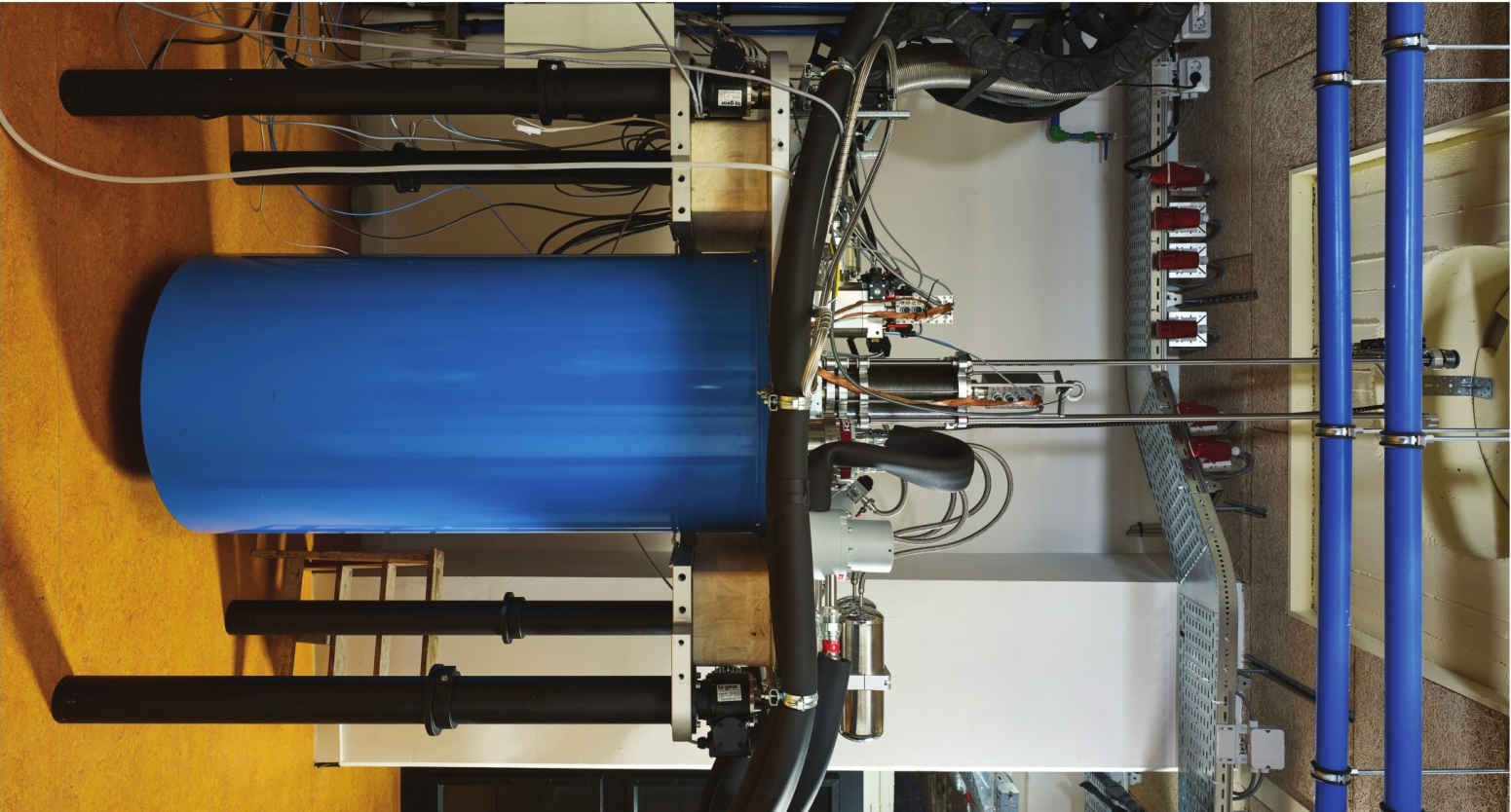

10种量子计算物理实现方法:Divincenzo判据[1]

军事与商业:量子计算的用武之地

近几年,无论是量子计算的硬件规模还是操作的保真度和可控性,都在稳定地增长,可以预见,在未来的几年内量子计算系统会在很多特定任务上表现出比传统计算机显著的优势。无论是在军事方面,还是在商业方面。

军事领域

当今时代,人类战争的形态已经由机械化转化为信息化,而实现这一转变的里程碑事件是1946年世界上第一台计算机的诞生。但是,随着信息技术的进一步发展,电子计算的瓶颈也逐渐凸显出来。为了进一步提高计算能力,世界各国的军事机构和公司都在相继开展量子计算的研究工作。自美国的“量子信息科学和技术发展规划”和旨在研发量子芯片的“微型曼哈顿计划”开始,不甘落后的日本、法国、德国等国家也制定了一系列关于量子计算的军事计划。作为军事大国,我国在量子计算的研究和应用上也不落人后,对光晶格中超冷原子自旋比特纠缠态操纵的首次实现,就是我国在量子计算领域研究的代表之作,这一成果也为量子计算的扩展应用奠定了基础。

量子计算可以应用在军事通信领域,将量子比特用作信息传输的载体,不仅可以使通信过程的传输速度更快、容量更大,还可以提高信息传输的安全性。量子通信可以提供一种相对于传统的密码体系来说更安全的新型密码体制。利用量子叠加原理,一旦有窃听者存在,在发送的信息中就会存在额外的误码,能被迅速地检测到,从而使密码传输具有极高的安全性。而更安全的密码传输,可以使军队在纷繁复杂的未来战斗的过程中,相互连通的方式更有保障,从而占据更大的主动性。值得一提的是,量子通信与传播介质无关,这与传统的通信技术相比是一个极大的优势;在一些特殊环境中,如深海等,仍然可以保证远距离通信。

随着量子卫星的成功发射,科研工作者如果后续将量子卫星组网,并与地面的通信网络协同合作,在可见的未来构建空间广域量子保密通信网络,甚至是可达全球覆盖,这在军事行动中将成为一柄利剑,未战先立于不败之地。通信技术将构建跨区域范围甚至是全球范围的量子通信网络系统,并具有极高的通信安全保障。

雷达系统是现代军队作战的探测器和指挥官,量子计算在雷达领域也具有巨大的应用潜力。现代战争中使用的雷达是发射电磁信号的相控阵雷达,雷达发射的电磁信号经过目标发射后,返回到雷达系统的接收机中,经过信号处理,我们就会知道敌方军事目标的位置、速度等重要信息。但是,隐身技术的飞速发展,向现代雷达的探测能力提出了巨大的挑战,提高雷达信号的探测灵敏度就成为各个军事机构研究的重点课题。利用量子不可克隆原理和量子叠加原理,将量子信息调制到雷达信号中,可以获得量子雷达,其灵敏度将远高于传统雷达。利用量子计算机对量子信号分析处理,将使我们迅速获得敌方军事目标的活动轨迹,这些信息会为我方部队提供精确打击的基础,对敌方而言则是“死亡的丧钟”。量子计算在雷达领域的使用,有望使未来军队在探测与反隐身作战方面迈上新的台阶。

除去军事通信和雷达领域之外,量子计算在军事成像领域也可以大显身手。利用量子计算的独特性质,可以实现量子光场,进而提高军事成像的分辨率。量子成像技术,可在没有目标的光路上得到探测目标的图像,在未来战场上具有的应用前景同样不可限量。

商业领域

我们相信,在未来的某日,稳定可控的量子计算机将会在众人期待中登上历史的舞台。从理论上来讲,这种计算机能够解决一切计算难题,因此投资界一致认为关于量子计算的投资将会带来长远的收益。实际上,虽然目前能解决实际问题的量子计算机还在研制中,但一旦有与量子计算相关的小设备投入生产和使用,对于投资者来说也必然是一笔可观的收入;而且这一天不会来得太晚,随着研究的不断突破, 3~5年内发生是大概率事件。在商业范畴,时间就代表着金钱甚至生命。更快的计算速度代表着更高的效率,基于量子计算开发的设备在金融、医疗、生物甚至人工智能等领域具有广阔的应用前景,并将带来可观的商业回报。

有关量子计算的设备崭露头角时,将会在哪些技术领域得到商业运用呢?根据量子计算的特点和相对于传统计算系统的优势,我们在这里做出大胆的假设:量子计算的初步应用应该会涉及数值模拟、优化和采样等需要处理庞大数据的领域。

数值模拟即通过数值计算和图像显示的方法,达到对工程问题和物理问题乃至自然界各类问题研究的目的。以对材料的性能极其相关的化学反应模拟为例,使用传统方法需要花费极大的财力和时间,而且很难研究出量子层面的分子间互动;而一旦引入量子计算,大规模短时间建模计算将不再是梦。基于量子计算,甚至可以在短时间之内建立庞大的备选材料数据库。传统方法对材料的模拟只能达到定性分析的水平,而量子计算能达到定量模拟的高度,并且还有预测新型材料的能力。不管是为了化学反应开发高效的催化剂,还是为了航天航空领域开发特殊性能的材料,或是为了医学领域开发更适合人体的医疗设备材料,量子力学的大容量和超快速都可以带来巨大的商业价值。IBM试验性量子计算集团的经理杰瑞·周(Jerry Chow)说:“在药物制造、药物设计、化工设计以及生物制药等领域,量子模拟很有潜力。”

优化是各行各业中都会面临的问题,在物理、社会等各种计量学科中,中心任务都是优化。下面以制造业的参数优化为例来简单地介绍一下优化的概念。参数优化是达到设计目标的一种方法,通过将设计目标参数化,采用优化方法,不断地调整设计变量,使得设计结果不断接近参数化的目标值。随着增材技术的稳定性应用,与之配套的优化技术也相应成为制造业在近几年的热点。但传统算法由于其本身的局限性,并不能为优化的发展提供基础,在解决优化问题上屡屡遇到困难;其原因在于传统算法中优化的核心是尝试寻找数学上可能存在的解,而好的方案的获得往往需要克服巨大的计算障碍。如果换一种思路,使用统计学的方法,同时在经典采样中引入量子现象,就可以利用量子现象的隧穿效应找到稀有但高质量的解决方案,事半功倍。这就比如面前有一堵墙挡住了我们的去路,传统方法在高墙之下一筹莫展,而量子辅助优化却宛如“崂山道士”般穿墙而过。

另外,量子计算还可被应用于采样技术。与统计学中常用的概率分布函数抽样不同,理想的量子电路可以从更大的概率分布函数中进行采样。而且有研究表明,只需要一个25层的网络,每层使用了一个7×7 量子比特的量子电路,就有望从经典方法不能采样的概率分布函数中采样。量子采样在机器学习中的推理和模式识别等方面将有极大的应用前景。

量子计算应用的先行者

量子计算强大的运算能力,使其成为诸如复杂问题优化、量子加密通信等领域的不二选择。为了在这个极富前景的领域开疆拓土,众多公司不惜投入极大的财力与人力开展相关的应用研究。

谷歌

作为搜索行业的巨头,谷歌公司希望通过量子计算来获得更好的人工智能和更好的复杂优化问题的解决方案。

谷歌在量子人工智能实验室(Quantum Artifcial Intelligence Lab,Qu AIL)拥有一台 D-Wave Systems 的量子计算机。该实验室由美国宇航局(NASA)以及位于加利福尼亚州芒廷维尤的美国宇航局艾姆斯研究中心(NASAAmes Research Center)的大学空间研究协会(Universities Space Research Association)共同办。

D-Wave Systems Inc是世界上第一家商用量子计算机公司,它与谷歌的交易是 D-Wave 历史上最大的一笔。谷歌及其合作伙伴拥有长达7年的最新 D-Wave 机器的访问权限,期间新一代D-Wave 系统将被安装在美国宇航局艾姆斯研究中心的设备上供其使用。D-Wave公司是量子计算机研究的开拓者。2007年,加拿大初创公司D-Wave Systems宣布,他们使用16个超导量子比特成功制成了量子计算机,这一消息震惊了世界。但是D-Wave的机器并没有使所有的量子比特发生纠缠,并且不能一个量子比特接着一个量子比特地编程(be programmed qubit by qubit),而是另辟蹊径,使用了一项名为“量子模拟退火”(quantum annealing)的技术。在该技术下,每个量子比特只和邻近的量子比特纠缠并交互,这并没有建立起一组并行计算,而是一个整体上的、单一的量子状态。D-Wave开发者希望把复杂的数学问题映射到该状态,然后使用量子效应寻找最小值。对于优化问题(比如提高空中交通的效率)来说,这是一项很有潜力的技术。

但批评者们立刻指出:D-Wave并没有攻克许多公认的量子计算难题,如错误修正(error correction)。包括谷歌和洛克希德马丁在内的几家公司购买并测试了D-Wave的设备,他们初步的共识是,D-Wave做到了一些能称之为量子计算的东西,而且在处理一些特定任务时,他们的设备确实比传统计算机要快。无论这到底算不算量子计算,D-Wave把IT行业的巨头们震醒了。硅谷企业家Chris Monroe说:“D-Wave确实打开了人们的眼界。他们让大家意识到量子计算机是有市场的,并且有强烈的需求。”几年内,各个公司纷纷投入到与它们的专业知识相关的量子计算领域去。

领导谷歌 Qu AIL 工作的 Hartmut Neven 及其团队最近发表了一篇有关其 D-Wave 2X 计算机的论文,它展示了该机器的计算执行速度能比一块经典的计算机芯片快 1 亿倍速的初步测试结果。早在 2013 年,该团队已利用 D-Wave 的机器在 Web 搜索、语音/图像模式识别、规划和行程安排、空中交通管理、机器人外太空任务等应用中进行了量子计算的探索,并支持任务控制中心的操作。

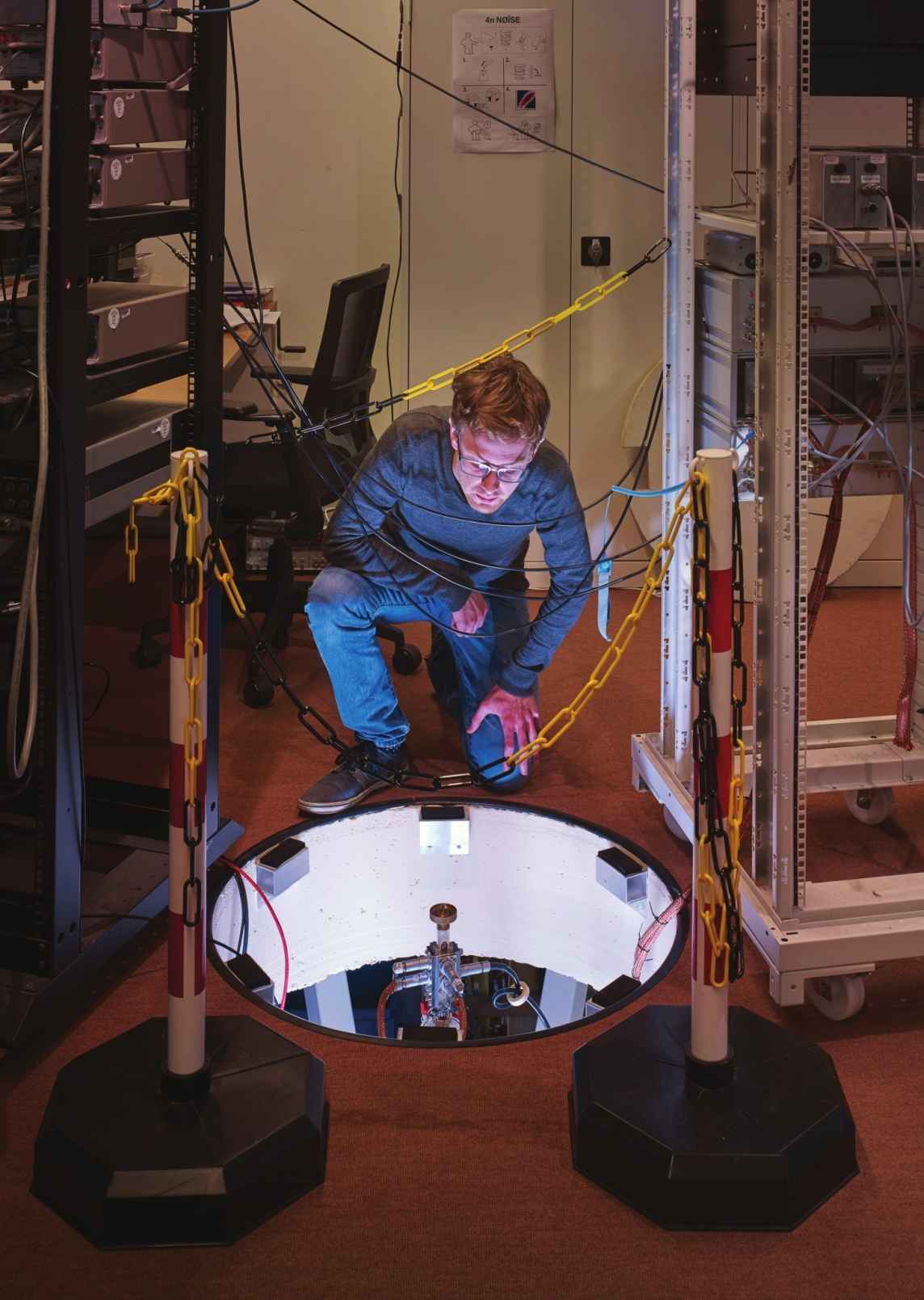

2014 年,为了减少机器学习与人类智能之间的差距——且为了在人工智能的新兴领域中取得领先地位——谷歌开始利用其在 D-Wave 机器上的经验并专注于开发自己的量子硬件。谷歌为此雇佣了圣巴巴拉市加利福尼亚大学(University of California,Santa Barbara)的一位超导量子比特专家John Martinis 及其团队,来建立谷歌的专属量子芯片。这之后,John Martinis团队宣布,他们已经建成了9个量子比特的机器,是目前世界上可编程的最大的量子计算机之一,而且他们正在尝试扩大规模。为了避免大堆缠绕的电线,他们正在2D平面结构上重建该系统。系统会铺设在一块晶圆上,所有的控制电路都被蚀刻在上面。

John Martinis团队如今已有30名科学家和工程师。2016年7月,他们用了3个超导量子比特来模拟氢分子的基态(ground state)能量,这展示了在模拟简单的量子系统上,量子计算机可以做到和传统计算机一样好。Martinis表示,这个结果预示了拥有“量子霸权”的计算设备的力量。他还认为,谷歌用1年时间创造出49个量子比特计算机的计划很赶时间,但有可能实现。

英特尔

与谷歌公司的出发点不同,英特尔公司对量子计算的研究则专注于利用量子计算在先进制造业、电子工业和更好的系统架构设计中受益。

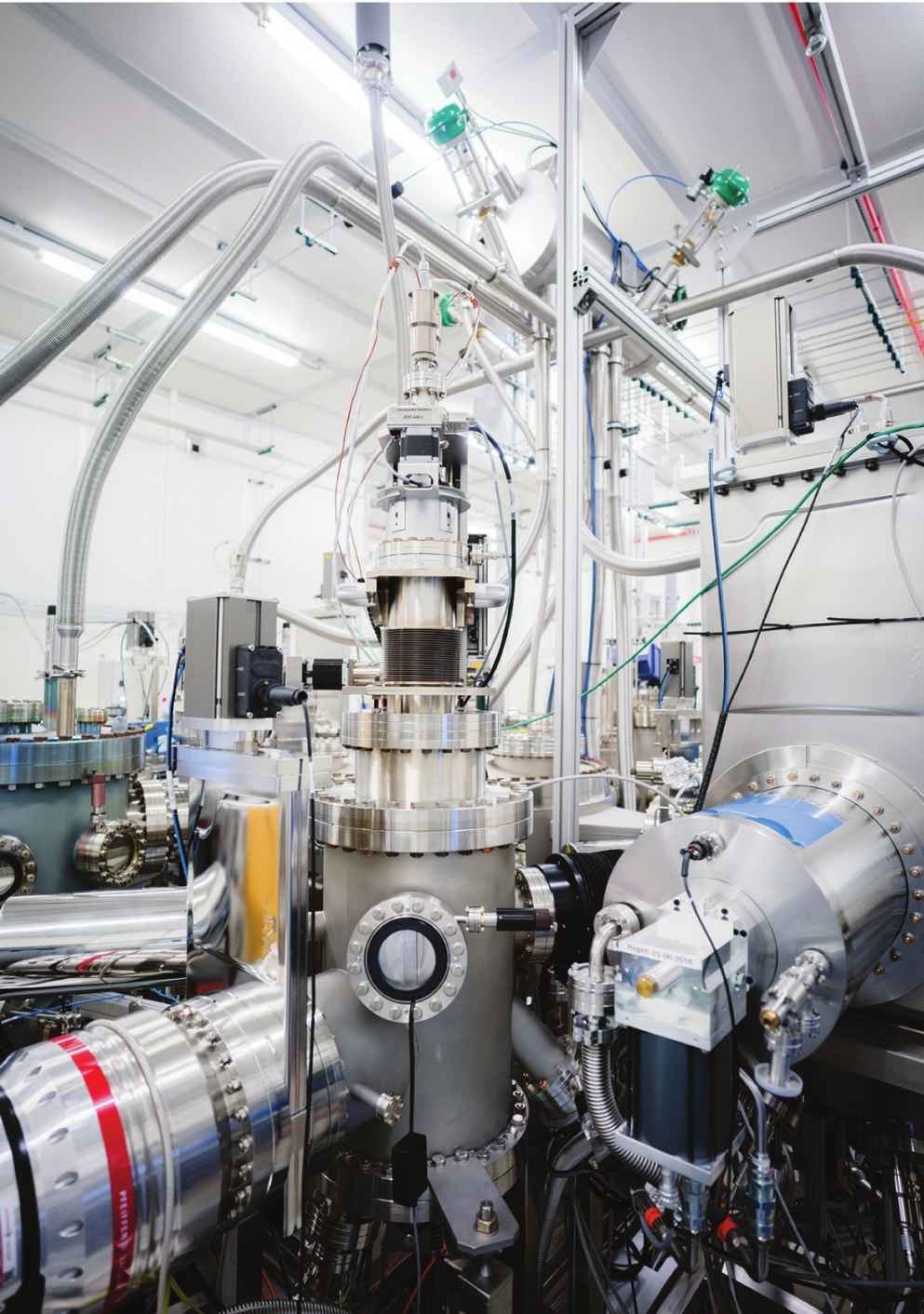

对量子计算最大的投资也来自英特尔。2015年,英特尔公司宣布将向荷兰代尔夫特理工大学的量子技术研究项目Qu Tech以及荷兰应用研究组织投资5000万美元,用于 10 年合作期的工程支持供给。英特尔专注于硅量子点(silicon quantum dots)技术,它经常被称作“人造原子”。一个量子点的量子比特是一块极小的材料,像原子一样,它身上的电子的量子态可以用0或1来表示。不同于离子或原子,量子点不需要激光来困住它。

早期的电子点用几近完美的砷化镓晶体制作,但研究人员们更倾向于硅,希望能借用半导体产业的巨大产能。Qu Tech技术负责人Leo Kouwenhoven说:“我认为英特尔属意于硅,毕竟那是他们最擅长的材料。”但是基于硅的量子比特研究大大落后于囚禁离子技术和超导量子技术。2016年,澳大利亚新南威尔士大学的一个研究团队才完成2个量子比特的逻辑门。

英特尔公司首席执行官Brian Krzanich 曾发表了一篇博客,详细描述了公司在量子计算领域的战略利益,以及电子工业和制造业的专业知识在量子计算实践方面的相关性。这也从侧面反映了英特尔公司在量子计算领域开疆拓土的雄心壮志。

微软

作为全球最大的计算机操作系统供应商,微软正在为量子计算机制造专用软件和硬件。

早在2005年,微软带领的一支研究团队就提出了一种在半导体——超导体混合结构中建造拓扑保护量子比特的方法。而微软公司量子计算研究的核心部门——Qu Ar C 部门成立于2011 年 12 月,其关注的重点是为可扩展的、容错的量子计算机的使用设计软件架构和算法。该机构值得关注的一项成就是LIQUi——一种用于量子计算的软件架构和工具套件。微软的Qu Ar C团队与全世界的许多大学都建立了紧密的合作关系,其中包括代尔夫特理工大学、Nils Bohr 研究所、悉尼大学、普渡大学、马里兰大学、苏黎世联邦理工学院和加州大学圣巴巴拉分校(UCSB)等知名学府。 2014年,微软透露自己在UCSB的校园内有一个名叫Station Q的小组正在研究拓扑量子计算(topological quantum computing)——旨在改善量子状态的控制设计。在Qu Ar C团队的软件和算法工作的基础上,Station Q 是微软一项跨世界的工作:将全世界的数学家、计算机科学家、量子物理学家和工程师集合起来构建混合超导/半导体设备,以用于受控环境中的应用,其最终目标是创造一种可扩展的、容错的通用量子计算机。

微软团队的研究表明,理论上拓扑量子计算机不需要在错误修正上花费那么多量子比特。

在量子计算研究火速发展的今天,微软绝不会停止自己前进的步伐。近期,微软已经投资了数个团队进行量子计算的研究尝试。这些团队近期的研究显示,量子计算中的关键载体“任意子”以电路中电流的模式进行移动。这些科学家已经很接近展示真正的量子比特了。微软研究团队的首席科学家Preskill说:“我认为在一两年内,我们就可以看到结果——拓扑量子比特确实存在。”

在国外的IT行业巨头重点研究量子计算的同时,我国的科学家和企业家们也不遑多让。2015 年 7 月,阿里巴巴的阿里云与中国科学院在上海建立了一个研究机构,叫作阿里巴巴量子计算实验室(Alibaba Quantum Computing Laboratory)。该实验室的目标是为电子商务和数据中心研究量子安全技术。阿里巴巴打算用量子计算机来开发更安全的电子商务和支持电子商务的数据中心。

致力于量子计算研究的公司和机构还远不止这些。自进入工业时代起,人类已经走过了蒸汽时代、电气时代和信息时代,而蒸汽机、电灯和电子计算机的发明,正是人类叩开新时代的大门的钥匙。在众多科研工作者的努力下,相信在不久的将来量子计算机就会实现,人类社会会随之进入“量子时代”吗?让我们拭目以待。

专家点评

张云泉

中国科学院计算机技术研究所研究员、博导,国家超级计算济南中心主任。

人类对新计算工具的创新和更快的计算速度的追求是永无止境的。

最早期的人类用绳子结绳计数,还只是满足于对自己猎取收获的统计和管理功能,那时的计算工具就是绳子,仅仅能够起到统计数量的目的。

中国是世界上最早发明算盘这一先进计算工具的国家,而且我个人认为算盘也是世界上最早具有并行计算能力的计算工具。算盘与绳子相比,已经具有加减的基本计算能力,根据珠算口诀,人的10个手指可以同时参与这一过程,从而有效地提高了人类对数据的处理速度。直到现在,仍然有一批熟练使用算盘的人,而且他们还举办比赛。

此后的中国人几乎满足于算盘的作用,基本没有再发明更先进的计算工具。而欧洲随着文艺复兴走出黑暗的中世纪时代,随着蒸汽机的发明和广泛使用以及资本主义商业活动的日益活跃,对计算速度的需求快速提升,人们急需一种新的计算工具。于是,以英国人为主的欧洲科学家们开始了对自动差分机的机械计算工具的研究竞赛。这也为后来的图灵计算机的提出奠定了坚实的基础。

基于此前对机械自动计算工具的坚实的研究基础,英国人在第二次世界大战中基于破译德军密码这一对计算能力的强烈需求,投入了最精锐的科学家研制自动破译密码的机械计算工具,并成功地破译了德军传奇式的恩尼格码密码机,对盟军赢得第二次世界大战做出了卓越的贡献。而在这其中起到关键作用的就是现代计算机的理论奠基人图灵。图灵最早提出了图灵计算机的理论基础,并提出了图灵测试。

真正意义上的现代计算机,是在第二次世界大战之后由美国人主导发明的,这其中的关键人物就是美国曼哈顿工程的科学家冯·诺依曼教授。他提出的存储程序计算机,也就是我们常说的冯·诺依曼体系结构计算机,是直到现在还在使用的计算机体系架构。虽然有科学家提出过非冯的新体系架构,但实际上其本质还是冯氏体系架构的范围,只不过做了一些扩充而已。所谓“孙悟空即使有七十二变和筋斗云,也翻不出如来佛的手掌心”。

而真正能够“跳出如来佛手掌心”的是拥有量子叠加能力的量子计算机。量子计算的概念最早是由美国物理学家费曼在1982年提出的。量子计算机是基于量子理论提出的,特别是量子同时处于0和1两种状态的特性,这与半导体同一时间只能处于0或1的状态截然不同。但是量子计算机的研制充满了艰难曲折,此前一直处于理论研究的阶段。

虽然美国宇航局、谷歌公司等机构合作开发的D-Wave量子模拟机对某些问题的求解速度已超过传统计算机的1亿倍,但学术界还是有许多人认为这不是真正的通用量子计算机。D-Wave 的机器并没有使所有的量子比特发生纠缠,并且不能一个量子比特接着一个量子比特地编程,而是另辟蹊径,使用了一项名为“量子模拟退火”(quantum annealing)的技术。该技术中,每个量子比特只和邻近的量子比特纠缠。最新版的D-Wave 2000Q量子计算机包含约2000个超导量子比特(qubits),是前一代量子计算机的2倍,售价仅为1500万美元,但是其性能也仅仅比当前最快的单个CPU或GPU快一些。就像《自然》杂志所解释的那样:D-Wave使用的量子比特相对来说比较简单,这使该公司能研制出首台经济可行的量子计算机,但成也萧何败也萧何,这种量子比特非常脆弱,且比其他实验室正在研发的量子比特更容易失去量子状态。

谷歌是世界公认的量子计算机领域的领头羊。谷歌进入量子计算的路径是极小的超导电路。原理是用一股无电阻电流沿着电流回路来回振荡,注入的微波信号使电流兴奋,从而让它进入叠加态。目前,谷歌已制造出9个量子比特的机器,并计划在2018年增加至 49个量子比特。这是一个极为关键的门槛。有学者预计,在50个量子比特左右,量子计算机就能达到“量子霸权”(quantum supremacy)。微软不久前也公布了自己的开发路径,它的选择是拓扑量子比特技术,是以“任意子”(anyons)作为基础。“任意子”是一种以 2D 形式存在的粒子,可用于构建超级计算机的模块并激发亚原子的物理属性。其原理是电子通过半导体结构时会出现准粒子,它们的交叉路径可以用来编写量子信息。

与上述两家公司选择的技术路径不同,英特尔公司正在努力利用硅晶体管的能力来制造量子计算机。英特尔在美国俄勒冈州波特兰的量子硬件工程师团队正与荷兰代尔夫特理工大学Qu Tech量子研究所的研究人员展开合作。英特尔公司声称,已经可以在芯片工厂中将量子计算机所需的超纯硅层加到标准芯片上。这一技术路线使得英特尔在众多研究量子位的工业和学术团体中表现突出。其他公司利用超导电路去实现量子位,但这样的量子位数量有限。此外,相对于超导材料,硅量子位的可靠性更好。

在国内通过不同方法开展量子计算研究的有中国科技大学、南京大学和中科院物理所等单位,近期中国的阿里巴巴公司也携手中国科技大学加入战团。2017年年初,中国科技大学首次实现了10个光子纠缠,再次刷新了光子纠缠态制备的世界纪录,向实现20个、30个光子的纠缠在特定问题的处理能力上超越经典商用计算机迈出了重要一步。

乐观的估计,实用的量子计算机在未来的5年之内就会投入使用。2025年左右,具有50个量子位运算能力的量子计算机将投入使用,并在计算能力上超越同时代的最快的超级计算机。当然,也有一些科学家很悲观,认为50年内量子计算机很难投入使用。这是量子计算机的一体两面,必须辩证地看待这个问题。未来几十年,超级计算与量子计算将共同存在和发展,超级计算擅长解决科学计算问题,量子计算擅长解决优化问题和机器学习问题,二者是互补的。目前的量子计算机还需要计算机的驱动,可以作为加速卡来使用。量子计算希望一个问题的输入和输出尽量少,计算量尽量大,越大越好。

Nature 以“2017年将使量子计算机从实验室走进现实”为题刊文,预计2017年该领域具有值得期待的突破。量子计算长期以来都被认为是20年以后才会实现的技术,但是2017年可能是这个领域改变其“仅限于研究”的印象的一年,量子计算正在从纯粹的科学转变到工程建造。目前,已经可以做到20个量子位的同时操作。

总之,随着摩尔定律在提出50年后逐渐失效,整个IT界都在期盼一种新的计算工具的出现,能够拯救摩尔定律。而量子计算机就是其中被寄予厚望的新计算工具之一。让我们拭目以待。

[1].#1-#7分别对应前面介绍的7个Divincenzo判据,▲暂无方案,■原理上可行,★可行性得到了比较充分的证实